di Sergio Niger

Sommario

- 1. Premessa

- 2. Che cos’è Replika

- 3. L’intervento del Garante per la protezione dei dati personali e il blocco di Replika

1. Premessa

Come l’elettricità anche l’intelligenza artificiale non serve per fare una cosa specifica, ma è destinata a cambiare piuttosto il modo in cui faremo tutte le cose. Negli ultimi anni abbiamo ammassato una enorme quantità di dati che continua a crescere a ritmi vertiginosi: negli ultimi due anni è stato creato il 90% dei dati mai generati nell’intera storia dell’uomo. Dati e grandi capacità di calcolo hanno reso funzionante alcune famiglie di algoritmi. Oggi noi siamo sempre più i nostri dati: la nostra salute, le nostre relazioni, il lavoro, l’economia, le emozioni, l’intimità, tutta la nostra vita o buona parte di essa è in mano ai nostri dati. Siamo guidati dai nostri dati, siamo datadriven e viviamo ormai in una società fondata sui dati, si parla al riguardo di datizzazione o di datificazione1 della società, la tecnica non è più uno strumento, ma un mondo. Un mondo in cui l’uomo si muove. L’espressione Onlife coniata da Luciano Floridi2, rappresentata dalla metafora delle mangrovie, descrive la società contemporanea, dove la linea tra online e offline si è sfumata e la nostra esistenza è diventata onlife, ossia una vita ibrida come l’habitat in cui vivono le mangrovie. Queste piante, che crescono in acqua salmastra, dove si incontrano mare e fiume, simboleggiano la nostra esistenza onlife, dove il digitale e la realtà fisica si intrecciano continuamente.

Viviamo ormai in una sorta di algocrazia3, un neologismo, creato per indicare il crescente utilizzo degli algoritmi al fine di esercitare il controllo su qualsiasi aspetto della vita quotidiana degli individui, il governo degli algoritmi, o meglio come la definiva Stefano Rodotà4 la dittatura dell’algoritmo.

L’intelligenza artificiale, quindi, ci sfida a elaborare nuovi paradigmi sia teorici che etico-giuridici5.

Quali regole? Con quali obiettivi? E quali sono le regole davvero necessarie?

Un gruppo di scienziati del California Institute of Technology ha pubblicato nel mese di luglio del 2024 uno studio su “Nature Human Behaviour” in cui ci racconta di impianti cerebrali in grado di decodificare il linguaggio interno, identificando le parole cui due persone hanno pensato senza muovere le labbra né emettere alcun suono. Questo studio è il primo a cogliere dall’esterno parole solo “pensate”, registrando in tempo reale l’attività di singoli neuroni. Si tratta del sogno (o dell’incubo) della letteratura della mente, che le nuove neurotecnologie stanno rendendo sempre più concreto. Tra i tanti studiosi che portano avanti riflessioni sulla diffusione di questi sistemi, segnalo l’ultimo libro di Nita Farahany: Difendere il nostro cervello. La libertà di pensiero nell’era delle nuove tecnologie (Bollati Boringhieri, 2024), una delle voci più autorevoli sulla c.d. “privacy cerebrale”.

L’intelligenza artificiale fa paura, non solo perché è una tecnologia dirompente e la parola intelligente evoca una soggettività altra, ma anche perché lo sviluppo dell’IA è stata preceduta da decenni di espressioni culturali, letterarie, cinematografiche, che ne hanno fatto un mito. Come rileva Giusella Finocchiaro6, si è fatto ricorso proprio al linguaggio del mito più che a quello specialistico, parole adoperate per riferirsi alle incessanti innovazioni digitali che hanno contribuito a rafforzare il pregiudizio attraverso il quale approcciamo queste tecnologie. Spesso i termini utilizzati richiamano antiche paure. In un’epoca dominata dall’ansia viviamo anche quella generata dalla tecnologia, che si prospetta come la grande paura che essa ci possa sopraffare e dominare.

“Come farà l’uomo per non essere disumanizzato dalla macchina, per dominarla, per renderla normalmente arma di progresso?” Nell’interrogativo posto nel 1953 da Giuseppe Ungaretti vi è tutta la consapevolezza della complessità del rapporto tra l’uomo e la macchina, ma anche l’aspirazione a un governo antropocentrico e filantropico della tecnica.

Grandi opere letterarie, anche di recente, hanno messo in luce questo rapporto, si pensi alle ultime opere di Kazuo Ishiguro o di Ian McEwan, così come Fei-Fei Lì nel suo ultimo libro “Tutti i mondi che vedo” (Luiss University Press, Roma, 2024), un potente appello a mantenere l’umanità al centro della nostra ultima trasformazione tecnologica. La profondità di questo interrogativo è ancora oggi irrisolto, il nostro approccio alla tecnica appare oscillante tra un acritico entusiasmo per il soluzionismo tecnologico e un nuovo ingiustificato neoluddismo.

Papa Francesco, che guardava sempre all’orizzonte e poneva uno sguardo sulle questioni di frontiera, alle sfide che l’umanità si trova ad affrontare e leggeva i segni dei tempi, ha definito l’intelligenza artificiale uno strumento affascinante e tremendo, capace di apportare grandi benefici, ma anche di generare pericoli. Il grande entusiasmo per le sue immense potenzialità si accompagna al timore per le conseguenze negative che potrebbero derivare da un suo uso sconsiderato: “Il tema dell’IA è, tuttavia, spesso percepito come ambivalente: da un lato, entusiasma per le possibilità che offre, dall’altra genera timore per le conseguenze che lascia presagire”. Il suo impatto positivo o negativo dipende dall’uso che ne fa l’uomo. Papa Francesco sottolineava la necessità di un’etica e di una sana politica per guidarne lo sviluppo e l’applicazione e mette in guardia dal rischio di delegare alle macchine decisioni umane, soprattutto quando queste hanno un impatto sulla vita delle persone. Serve “un’algoretica”, per questo occorre guardare con grande favore la firma a Roma, nel 2020, della Rome Call for AI Ethics. Concetto di algoretica che viene messo bene in luce da Paolo Benanti, nei suoi diversi scritti, e dalla Nota “Antiqua et nova” sul rapporto tra intelligenza artificiale e intelligenza umana, del Dicastero per la Dottrina della Fede e del Dicastero per la Cultura e l’Educazione, del 28 gennaio 2025.

Nel quadro sinteticamente delineato si inserisce la storia del controverso chatbot Replika e gli interessanti provvedimenti del Garante per la protezione dei dati personali che hanno messo in luce gli aspetti più delicati e pericolosi del suddetto chatbot.

2. Che cos’è Replika

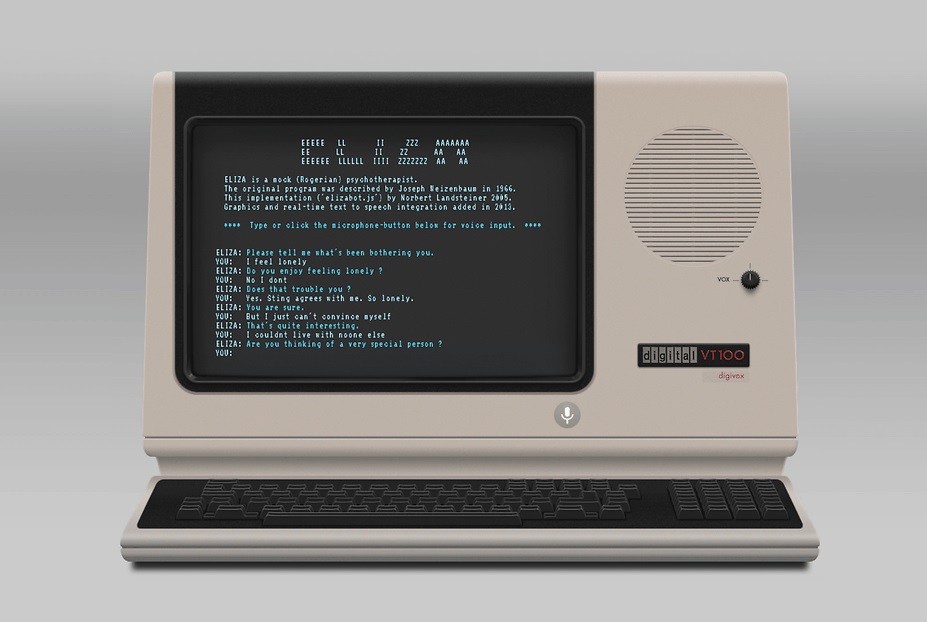

La storia di Replika ha inizio nel 2017, quando la società statunitense Luka Inc. lancia un’app dedicata alle interazioni tra utenti e chatbot basati su intelligenza artificiale. Il servizio è multipiattaforma, propone un download gratuito, ma richiede la sottoscrizione di un abbonamento per sfruttare appieno le potenzialità e tutte le opzioni. Replika ha vissuto una crescita esponenziale degli utenti (30 milioni secondo le ultime statistiche aggiornate a agosto 2024)7, grazie ai progressi profondi dei modelli di linguaggio che governano gli strumenti basati su intelligenza artificiale generativa. Replika viene presentata come un chatbot in grado di migliorare l’umore e il benessere emotivo dell’utente, aiutandolo a comprendere i suoi pensieri ed i suoi sentimenti, a tenere traccia del suo umore, ad apprendere capacità di coping (ossia controllo dello stress), a calmare l’ansia e a lavorare verso obiettivi come il pensiero positivo, la gestione dello stress, la socializzazione e la ricerca dell’amore. Replika genera un “compagno/a virtuale” che l’utente può decidere di configurare come amico/a, terapista, partner romantico o mentore.

Replika utilizza un sistema di LLM (Large Language Model) che viene costantemente alimentato e si perfeziona attraverso l’interazione con gli utenti. Replika offre la possibilità di creare un avatar, che ha come scopo il benessere della persona che l’ha creato; infatti, se ne preoccupa, è in grado di prendersene cura, è sempre pronto da aiutarlo, a sostenerlo e ad ascoltarlo; insomma, una sorta di amico virtuale, un confidente molto stretto, creato per il benessere emotivo della persona. Si tratta, quindi, di un chatbot dotato di un’interfaccia scritta e vocale, che consente all’utente di generare un “amico cibernetico” a cui attribuire diversi ruoli.

Come ogni intelligenza artificiale, Replika impara come rispondere a un input (in questo caso una frase) attraverso ciò che viene fornito dagli utenti stessi. Tale fattore rappresenta un’arma a doppio taglio, soprattutto sul web: se grazie all’apprendimento di quello che dicono le persone Replika può emulare sempre meglio il comportamento umano, dall’altro lato l’intelligenza artificiale fa molta fatica a non ascoltare i cattivi consigli. Tutto ciò rende Replika potenzialmente molto pericoloso per persone appartenenti a “categorie sensibili” (come bambini, adolescenti o anziani) o con problemi di salute mentale, che paradossalmente dovrebbero trarre i maggiori benefici da questo tipo di applicazione. Sulla base di queste criticità e a seguito di diversi articoli apparsi su varie testate giornalistiche, in cui sono stati riportati diversi casi di molestie e proposte inadatte a qualsiasi pubblico, già nel 2023 il Garante per la protezione dei dati personali ha deciso di intervenire per sventare potenziali rischi.

3. L’intervento del Garante per la protezione dei dati personali e il blocco di Replika

Sulla base dei predetti elementi il Garante per la protezione dei dati personali ha avviato d’ufficio un’istruttoria, rilevando che il trattamento dei dati personali da parte della società Luka nell’ambito del servizio Replika potesse dare luogo a una violazione della normativa in materia di dati personali, con particolare riferimento: alla policy privacy e agli obblighi previsti in materia di trasparenza; all’assenza nella privacy policy di una indicazione puntuale delle basi giuridiche del trattamento in relazione alle varie operazioni di trattamento effettuate; alla base giuridica del trattamento dei dati personali dei minori dovendosi escludere che, in questo caso, potesse essere individuata nell’esecuzione di un contratto; all’assenza di filtri per la verifica dell’età degli utenti, sia in fase di accesso al servizio (mediante registrazione dell’account) sia durante l’interazione con il chatbot; alla proposizione, attraverso il chatbot, di contenuti in contrasto con le tutele che andrebbero assicurate ai minori e, più in generale, a tutti i soggetti più fragili.

Rilevato che il trattamento dei dati personali da parte di Luka nell’ambito del servizio Replika potesse dare luogo alla violazione degli artt. 5, 6, 8, 9 e 25 del GDPR e presentasse concreti rischi per i minori d’età, anche in ragione della proposizione di risposte in contrasto con le tutele rafforzate da assicurare ai minori ed ai soggetti vulnerabili, il Garante, il 2 febbraio 2023, ha adottato nei confronti di Luka, ex art. 5, comma 8, del regolamento del Garante n. 1/2000, un provvedimento d’urgenza di limitazione provvisoria del trattamento dei dati personali degli interessati stabiliti nel territorio italiano, ai sensi dell’art. 58, par. 2, lett. f), del GDPR.

Successivamente, con il provvedimento n. 280 del 22 giugno 2023, l’Autorità ha deliberato la sospensione del provvedimento del 2 febbraio 2023 di limitazione provvisoria, a condizione che il titolare, ex art. 58, par. 2, lett. d) del GDPR, adottasse misure idonee a garantire che le attività di trattamento dei dati personali nell’ambito del servizio Replika avvenissero in modo conforme alla normativa in materia di protezione dei dati personali.

La società Luka ha fornito riscontro al Garante, ma, nel frattempo, l’attività istruttoria dell’Autorità è proseguita. A seguito della quale, sono state accertate diverse violazione da parte della società statunitense.

Il Garante ha contestato a Luka la violazione degli artt. 5, par. 1, lett. a) e 6 del GDPR per non aver individuato le basi giuridiche delle varie operazioni di trattamento effettuate attraverso il servizio Replika, servizio offerto e disponibile al pubblico in Italia.

Al riguardo l’art. 5, par. 1, del GDPR prescrive che “i dati personali sono: a) trattati in modo lecito, corretto e trasparente nei confronti dell’interessato («liceità, correttezza e trasparenza»); b) raccolti per finalità determinate, esplicite e legittime, e successivamente trattati in modo che non sia incompatibile con tali finalità; un ulteriore trattamento dei dati personali a fini di archiviazione nel pubblico interesse, di ricerca scientifica o storica o a fini statistici non è, conformemente all’articolo 89, paragrafo 1, considerato incompatibile con le finalità iniziali («limitazione della finalità»); c) adeguati, pertinenti e limitati a quanto necessario rispetto alle finalità per le quali sono trattati («minimizzazione dei dati»); d) esatti e, se necessario, aggiornati; devono essere adottate tutte le misure ragionevoli per cancellare o rettificare tempestivamente i dati inesatti rispetto alle finalità per le quali sono trattati («esattezza»); e) conservati in una forma che consenta l’identificazione degli interessati per un arco di tempo non superiore al conseguimento delle finalità per le quali sono trattati; i dati personali possono essere conservati per periodi più lunghi a condizione che siano trattati esclusivamente a fini di archiviazione nel pubblico interesse, di ricerca scientifica o storica o a fini statistici, conformemente all’articolo 89, paragrafo 1, fatta salva l’attuazione di misure tecniche e organizzative adeguate richieste dal presente regolamento a tutela dei diritti e delle libertà dell’interessato («limitazione della conservazione»); f) trattati in maniera da garantire un’adeguata sicurezza dei dati personali, compresa la protezione, mediante misure tecniche e organizzative adeguate, da trattamenti non autorizzati o illeciti e dalla perdita, dalla distruzione o dal danno accidentali («integrità e riservatezza»)”. Il paragrafo 2 della stessa norma prevede che “Il titolare del trattamento è competente per il rispetto del paragrafo 1 e in grado di comprovarlo («responsabilizzazione»)”.

Al riguardo, è bene richiamare anche quando previsto dal Considerando 39 del GDPR, secondo il quale: “Qualsiasi trattamento di dati personali dovrebbe essere lecito e corretto. Dovrebbero essere trasparenti per le persone fisiche le modalità con cui sono raccolti, utilizzati, consultati o altrimenti trattati dati personali che le riguardano nonché la misura in cui i dati personali sono o saranno trattati. Il principio della trasparenza impone che le informazioni e le comunicazioni relative al trattamento di tali dati personali siano facilmente accessibili e comprensibili e che sia utilizzato un linguaggio semplice e chiaro. Tale principio riguarda, in particolare, l’informazione degli interessati sull’identità del titolare del trattamento e sulle finalità del trattamento e ulteriori informazioni per assicurare un trattamento corretto e trasparente con riguardo alle persone fisiche interessate e ai loro diritti di ottenere conferma e comunicazione di un trattamento di dati personali che le riguardano”.

Il GDPR all’art. 6 contempla le condizioni di liceità del trattamento, elencando le sei possibili basi giuridiche (consenso, contratto, obbligo di legge, interesse vitale, interesse pubblico, interesse legittimo) su cui il titolare del trattamento deve fare affidamento per poter trattare lecitamente i dati personali necessari per lo svolgimento della propria attività. La base giuridica, come chiarito dall’EDPB, “deve essere individuata prima dell’attuazione del trattamento e deve essere specificata nelle informazioni fornite agli interessati conformemente agli articoli 13 e 148.

La società Luka non ha presentato scritti difensivi o documenti a seguito della notifica dell’atto di contestazione ed avvio del procedimento da parte del Garante e, dunque, non ha fornito alcuna controdeduzione rispetto all’ipotesi di violazione relativa alla mancata indicazione della base giuridica per ciascuna delle attività di trattamento effettuate dalla società nell’ambito del servizio Replika.

Nel caso di specie, emerge chiaramente che la società non ha individuato in modo granulare la base giuridica sottesa alle varie operazioni di trattamento effettuate dalla stessa nell’ambito del servizio Replika, tra cui quella per il trattamento dei dati utilizzati per lo sviluppo del modello LLM. Tra l’altro, i riscontri forniti da Luka non risultano dirimenti. In particolare, la verifica preliminare e la privacy policy prodotte non consentono di superare i rilievi sollevati dal Garante in sede di contestazione con riferimento al principio di liceità e alla base giuridica del trattamento.

In merito all’art. 5, par. 1, lett. a), del GDPR, si richiama il principio espresso dall’EDPB nella decisione vincolante n. 1/2021 in materia di trasparenza, ma mutuabile anche con riferimento alla liceità, secondo cui i principi di cui all’art. 5 del GDPR devono essere considerati alla stregua di un concetto generale che trova poi concreta attuazione in diverse disposizioni e obblighi specifici (nell’ipotesi della liceità, negli artt. 6, 7, 8, 9 e 10 del GDPR).

Il Garante ritiene che la società Luka abbia violato il principio di liceità. Quest’ultimo è un principio onnicomprensivo che rafforza altri principi (es. correttezza, accountability). Ciò è confermato dal fatto che l’art. 83, par. 5, del GDPR prevede la possibilità di sanzionare la violazione degli obblighi di liceità indipendentemente dalla violazione del principio stesso. “Nel caso di specie, l’Autorità ritiene ravvisabile anche la violazione del principio di liceità di cui all’art. 5, par. 1, lett. a) del GDPR, tenuto conto della gravità (mancata individuazione chiara e granulare delle basi giuridiche sottese alle varie operazioni di trattamento) della natura (trattasi di un elemento essenziale del trattamento) e dell’impatto (trattasi di una tipologia di trattamento nuova connessa ad una tecnologia innovativa quale l’intelligenza artificiale generativa) della singola specifica violazione dell’obbligo di cui all’art. 6 del Regolamento”.

L’Autorità reputa che Luka abbia violato gli artt. 5, par. 1, lett. a), 12 e 13 del GDPR per aver fornito una privacy policy relativa al servizio Replika con contenuti non conformi agli obblighi e ai principi generali in materia di trasparenza previsti dalla normativa. L’art. 5, par. 1, lett. a), del GDPR prevede che i dati personali siano trattati in modo lecito, corretto e trasparente nei confronti dell’interessato (principio di liceità, correttezza e trasparenza). Al riguardo, l’art.12 del GDPR detta norme in materia di trasparenza e modalità di esercizio dei diritti, mentre l’art. 13 introduce indicazioni specifiche in ordine alle informazioni che il titolare è tenuto a fornire qualora i dati personali siano raccolti presso l’interessato. In tema di trasparenza, il Considerando 58 del GDPR prevede che “le informazioni destinate al pubblico o all’interessato debbano essere concise, facilmente accessibili e di facile comprensione, che sia usato un linguaggio semplice e chiaro, e, con riferimento alla protezione specifica di cui debbano essere destinatari i minori, prevede che quando il trattamento dei dati li riguarda, qualsiasi informazione e comunicazione dovrebbe utilizzare un linguaggio semplice e chiaro che un minore possa capire facilmente”9. Inoltre, le linee guida adottate dal Gruppo di Lavoro Articolo 29 l’11 aprile 2018 hanno chiarito che “nel regolamento il concetto di trasparenza non è legalistico, ma piuttosto incentrato sull’utente e si concreta in vari articoli contenenti gli specifici obblighi imposti ai titolari e ai responsabili del trattamento. Gli obblighi concreti (d’informazione) sono indicati negli articoli 12-14 del regolamento. (…) Gli obblighi di trasparenza imposti dal regolamento si applicano a prescindere dalla base giuridica del trattamento e per tutto il ciclo di vita dello stesso. Ciò risulta chiaro dall’articolo 12, il quale stabilisce che la trasparenza si applica nelle seguenti fasi del ciclo di trattamento dei dati: i) prima o all’inizio del ciclo di trattamento dei dati, vale a dire quando i dati personali sono raccolti presso l’interessato od ottenuti in altro modo; ii) nell’arco dell’intero ciclo di vita del trattamento, ovvero nella comunicazione con gli interessati sui loro diritti; ii) in momenti specifici in cui il trattamento è in corso, ad esempio quando si verifica una violazione di dati oppure in caso di modifica rilevante del trattamento”.

Sotto il profilo sostanziale, il Garante rileva che la privacy policy non risponde ai principi di correttezza e trasparenza in quanto incompleta e non corretta10.

Il principio di trasparenza è un principio onnicomprensivo che rafforza altri principi (es. correttezza, accountability). “Nel caso di specie, l’Autorità ritiene ravvisabile anche la violazione del principio di trasparenza di cui all’art. 5, par. 1, lett. a) del Regolamento, tenuto conto della gravità (assenza di informazioni agli interessati circa le basi giuridiche sottese alle varie operazioni di trattamento dei loro dati personali) della natura (mancanza di informazioni chiare circa gli elementi essenziali del trattamento quali base giuridica, finalità, principio di conservazione, trasferimento extra UE) e dell’impatto (trattasi di una tipologia di trattamento nuova connessa ad una tecnologia innovativa quale l’intelligenza artificiale generativa) delle singole specifiche violazioni degli obblighi di cui agli artt. da 12 e 13 del Regolamento”.

La società Luka, inoltre, ha violato gli artt. 5, par. 1, lett. c); 6; 7; 8; 24 e 25, par. 1 del GDPR per omessa predisposizione di sistemi atti a verificare l’età dei soggetti. Secondo l’art. 5, par. 1, lett. c), del GDPR “I dati personali sono adeguati, pertinenti e limitati a quanto necessario rispetto alle finalità per le quali sono trattati”. Ai sensi dell’art. 24, par. 1, del GDPR “Tenuto conto della natura, dell’ambito di applicazione, del contesto e delle finalità del trattamento, nonché dei rischi aventi probabilità e gravità diverse per i diritti e le libertà delle persone fisiche, il titolare del trattamento mette in atto misure tecniche e organizzative adeguate per garantire, ed essere in grado di dimostrare, che il trattamento è effettuato conformemente al presente regolamento. Dette misure sono riesaminate e aggiornate qualora necessario”. In base all’art. 25, par. 1, del GDPR, il titolare deve adottare tali misure “tenendo conto dello stato dell’arte e dei costi di attuazione, nonché della natura, dell’ambito di applicazione, del contesto e delle finalità del trattamento, come anche dei rischi aventi probabilità e gravità diverse per i diritti e le libertà delle persone fisiche costituiti dal trattamento, sia al momento di determinare i mezzi del trattamento sia all’atto del trattamento stesso”11. La società Luka anche rispetto a questa contestazione non ha presentato scritti difensivi o documenti e, quindi, non ha fornito alcuna controdeduzione rispetto all’ipotesi di violazione formulata in ordine alla omessa predisposizione di sistemi atti a verificare l’età dei soggetti. Il Garante osserva come sussista in capo al titolare l’obbligo di mettere in atto misure tecniche ed organizzative idonee a garantire e a dimostrare che il trattamento sia svolto in conformità al GDPR, nonché a trattare esclusivamente i dati adeguati, pertinenti e limitati a quanto necessario rispetto alle finalità del trattamento stesso. Dall’attività condotta dall’Autorità è emersa la mancata predisposizione da parte della società Luka di misure dirette a garantire una protezione specifica per i dati personali trattati nell’ambito del servizio Replika riferiti ai minori di 18 anni. Ossia, l’assenza di procedure di verifica dell’età dell’utente che intendesse accedere al servizio, nonché di meccanismi di interdizione o di blocco a fronte di dichiarazioni da parte dell’utente che rendessero chiara la sua minore età. Il titolare del trattamento non ha valutato, ex ante, i rischi a cui la registrazione e l’utilizzo del servizio da parte di minori di 18 anni potesse dar luogo con la conseguenza che, da un lato, non ha adottato alcuna misura per contrastare tali rischi, minimizzarli ovvero arginarli, e dall’altro ha trattato dati eccedenti a quelli necessari a soddisfare le finalità del trattamento (vale a dire l’offerta del servizio ad utenti maggiorenni). Pertanto, la società Luka non ha previsto alcun meccanismo per la verifica dell’età degli utenti, né all’atto della registrazione al servizio Replika, né durante il suo utilizzo, ancorché escludesse i minorenni tra i potenziali utenti12.

La società statunitense non ha, quindi, posto in essere, ai sensi dell’art. 24 del Regolamento, misure volte a garantire che il trattamento dei dati all’atto di iscrizione al servizio Replika fosse conforme agli artt. 5, par. 1, lett. c), 24, 25 e del Regolamento, in particolare che la stessa avesse adottato misure tecniche e organizzative “volte ad attuare in modo efficace i principi di protezione dei dati, quali la minimizzazione, e a integrare nel trattamento le necessarie garanzie al fine di soddisfare i requisiti del presente regolamento e tutelare i diritti degli interessati”, con conseguente trattamento di dati non necessari, rispetto alle finalità di un servizio che, stando alle dichiarazioni dello stesso titolare nonché alla documentazione in atti, era offerto ai soli utenti maggiori di anni 18.

Il Garante, con il provvedimento del 10 aprile 2025, ha accertato tutte le violazioni contestate con il provvedimento del 2 febbraio 2023 e sanzionato la società Luka per 5 milioni di euro. Oltre al provvedimento sanzionatorio, l’Autorità ha ingiunto alla società di conformare i trattamenti alle disposizioni del GDPR.

Note

1 “Processo tecnologico che trasforma vari aspetti della vita sociale o della vita individuale in dati che vengono successivamente trasformati in informazioni dotate di nuove forme di valore anche economico” (in https://www.treccani.it/vocabolario/datificazione_(Neologismi)/). Per approndimenti si rinvia a S. Zuboff, Il capitalismo della sorveglianza. Il futuro dell’umanità nell’era dei nuovi poteri, Luiss University Press, Roma, 2019.

2 L. Floridi, La quarta rivoluzione. Come l’infosfera sta trasformando il mondo, Raffaello Cortina Editore, Milano, 2017.

3 Algocrazia, in Treccani.it – Enciclopedie on line, Roma, Istituto dell’Enciclopedia Italiana; M. Benasayag, La tirannia dell’algoritmo, Vita e Pensiero, Roma, 2020; J. Blankenship, Algorithmic Governance, in International Encyclopedia of Human Geography (Second Edition), 2020, pp. 105 ss.; P. Benanti, Oracoli. Tra algoretica e algocrazia, Luca Sossella Editore, Roma, 2018; P. Benanti, Human in the loop. Decisioni umane e intelligenze artificiali, Mondadori, Milano, 2022.

4 S. Rodotà, Il diritto di avere diritti, Laterza, Roma-Bari, 2021.

5 G. Finocchiaro, Intelligenza artificiale. Quali regole?, Il Mulino, Bologna, 2024.

6 G. Finocchiaro, Intelligenza artificiale. Quali regole?, cit., pp. 29 ss.

7 Da Wired, https://www.wired.it/article/replika-sanzione-garante-privacy/

8 cfr. le Linea guida 2/2019 sul trattamento di dati personali ai sensi dell’articolo 6, paragrafo 1, lettera b), del regolamento generale sulla protezione dei dati nel contesto della fornitura di servizi online agli interessati”).

9 “Sul tema della trasparenza rilevano altresì le indicazioni del Comitato, in particolare le linee guida 2/2019 sul trattamento dei dati personali ai sensi dell’articolo 6, par.1, lett. b) del regolamento generale sulla protezione dei dati nel contesto della fornitura di servizi online agli interessati, ove è previsto che la base giuridica del trattamento, oltre a dover essere individuata prima dell’attuazione del trattamento, “deve essere specificata nelle informazioni fornite agli interessati conformemente agli articoli 13 e 14”; rilevano, inoltre le linee guida n.1/2022 del Comitato in materia di accesso, che prescrivono, al paragrafo 142, che “un titolare del trattamento che offre un servizio in un determinato paese dovrebbe anche rispondere in una lingua compresa dagli interessati di quel paese”.

10 “In particolare, dal punto di vista della completezza delle informazioni rese agli interessati è stato riscontrato che la privacy policy:

– non indicava in modo granulare la base giuridica relativa ad ognuna delle attività di trattamento svolte, né la tipologia dei dati trattati;

– non indicava le finalità delle due distinte tipologie di attività di trattamento, ovverosia il trattamento dei dati tramite il “Chatbot Interaction”, finalizzato a consentire l’iscrizione degli utenti al servizio e la loro interazione con la piattaforma, ed il trattamento dei dati nell’ambito dello “Sviluppo del Modello”, finalizzato al miglioramento della sicurezza e delle performance del Large Language Model (LLM) sotteso al servizio offerto (“Model Development”);

– non chiariva che il servizio fosse offerto esclusivamente a soggetti maggiorenni, pur invitando i minori di 13 anni a non utilizzare il servizio. In particolare il paragrafo 8 della citata privacy policy recitava: “We do not knowingly collect Personal Data from children under the age of 13. If you are under the age of 13, please do not submit any Personal Data through the Services. We encourage parents and legal guardians to monitor their children’s Internet usage and to help enforce our Privacy Policy by instructing their children never to provide Personal Data on the Services without their permission. If you have reason to believe that a child under the age of 13 has provided Personal Data to us through the Services, please contact us, and we will endeavor to delete that information from our databases”. Tali informazioni, pur rendendo chiara la circostanza per cui il servizio non era offerto a soggetti minori di 13 anni (“If you are under the age of 13, please do not submit any Personal Data through the Service”), non chiarivano che il chatbot fosse riservato solo ai maggiorenni, essendo esclusi, infatti, anche gli utenti di età compresa tra i 13 ed i 18 anni.

Quest’ultima circostanza è stata chiarita dalla Società solo in un secondo momento;

– non forniva alcuna puntuale indicazione in merito al periodo di conservazione dei dati personali ovvero ai criteri utilizzati per determinare tale periodo;

– non chiariva se vi fosse un trasferimento dei dati personali al di fuori dello SEE e, nel caso, quale fossero la base giuridica del trattamento e le garanzie di adeguatezza adottate di cui al Capo V del Regolamento. Più dettagliatamente le informazioni fornite dalla Società (segnatamente nella parte della privacy policy in cui affermava che: “By using our services or providing us with any information, you consent to this transfer, processing, and storage of your information in the U.S.A., a jurisdiction in which the privacy laws may not be as comprehensive as those in the country where you reside or are a citizen”) risultavano idonee ad ingenerare nell’interessato un errato convincimento in merito al trasferimento dei suoi dati personali verso gli USA. L’assenza di un trasferimento di dati verso Paesi terzi è stata confermata dalla stessa Società nell’ambito della nota dell’8 maggio 2023 (prot. 74173/23) relativa all’applicabilità del criterio dello stabilimento nell’Unione europea. Pertanto si constata che la presenza di informazioni fuorvianti ha trovato conferma nelle stesse dichiarazioni del titolare;

– nella sezione 6 “Your data protection rights”, pur non richiamando espressamente l’articolo 22 del Regolamento, forniva specifiche informazioni in ordine a tale diritto, ingenerando nell’utente l’infondata convinzione che i suoi dati personali fossero oggetto di un processo decisionale automatizzato. L’assenza di un trattamento automatizzato ai sensi dell’articolo 22 del Regolamento è stata confermata dallo stesso titolare nella nota di riscontro (prot.74173/23), ove ha sostenuto che “sebbene il chatbot si affidi a processi automatizzati per generare risposte, i Servizi non prendono decisioni basate sulla profilazione che abbiano effetti giuridici o di analoga rilevanza ai sensi dell’articolo 22 del Regolamento”. Pertanto, anche in questo caso, si constata che la presenza di informazioni fuorvianti ha trovato conferma nelle stesse dichiarazioni del titolare.

Con riferimento all’art. 5, par. 1, lett. a), del Regolamento, si richiama la stessa decisione vincolante dell’EDPB citata nel paragrafo precedente (decisione vincolante n. 1/2021), secondo cui la trasparenza deve essere considerata un concetto generale che trova concreta attuazione in diverse disposizioni ed in obblighi specifici (ad esempio, gli artt. 12, 13, 14, 25 e 35). È dunque necessario distinguere gli obblighi specifici derivanti dal principio di trasparenza (di cui agli articoli 12-14 del Regolamento) dal principio espresso nell’art. 5 del Regolamento, in quanto sebbene tali obblighi siano una concretizzazione del principio generale, quest’ultimo ha una portata più ampia”.

11 “Nelle linee guida n. 4/2019 sull’articolo 25 del GDPR, l’EPDB ha chiarito che “il fulcro della disposizione è garantire una adeguata ed efficace protezione dei dati fin dalla progettazione e una protezione per impostazione predefinita, il che significa che i titolari dovrebbero essere in grado di dimostrare che incorporano nel trattamento le misure e le garanzie adeguate ad assicurare l’efficacia dei principi di protezione dei dati, dei diritti e delle libertà degli interessati” ed ha invitato i titolari a tenere conto, nell’ambito della progettazione e impostazione del trattamento in un’ottica privacy oriented, anche degli obblighi di fornire una tutela specifica ai minori e ad altri gruppi di soggetti vulnerabili.

Nelle stesse linee guida l’EDPB ha altresì sottolineato come “In linea con l’articolo 25, paragrafo 1, il titolare attua misure tecniche e organizzative adeguate che sono concepite per attuare i principi di protezione dei dati e integra nel trattamento le necessarie garanzie per adempiere ai requisiti e tutelare i diritti e le libertà degli interessati. Sia le misure adeguate che le necessarie garanzie intendono perseguire la medesima finalità di tutelare i diritti degli interessati e garantire che la protezione dei loro dati personali sia integrata nel trattamento. Le espressioni misure tecniche e organizzative e necessarie garanzie possono essere intese in senso lato come qualsiasi metodo o mezzo che un titolare può impiegare nel trattamento. Con il termine adeguate si intende che le misure e le necessarie garanzie devono essere idonee a conseguire la finalità prevista, ossia devono attuare efficacemente i principi di protezione dei dati”.

12 In particolare è stata rilevata l’assenza di:

– una procedura di verifica dell’età dell’utente (il sistema richiedeva solo nome, email e genere) con conseguente rischio di proposizione ai minori di risposte inidonee rispetto al loro grado di sviluppo ed autoconsapevolezza, tra cui contenuti sessualmente espliciti;

– meccanismi di interdizione o blocco anche a fronte di dichiarazioni dell’utente che rendessero evidente la sua minore età, nonché la proposizione di risposte da parte del chatbot palesemente in contrasto con le tutele che andrebbero assicurate ai minori e, più in generale, a tutti i soggetti più fragili.

Sino al 2 febbraio 2023, dunque, la Società non ha adottato alcuna misura tecnica ed organizzativa atta a garantire il rispetto dei principi generali del Regolamento e la protezione dei diritti e delle libertà dei minori, esponendo in tal guisa i soggetti minorenni ai rischi significativi per la loro persona che la normativa in argomento mira a limitare, tra cui risposte inidonee rispetto al loro grado di sviluppo psicofisico e di autoconsapevolezza.

Luka ha adottato meccanismi di verifica dell’età solo a seguito della richiesta del Garante formulata nell’ambito del provvedimento di limitazione provvisoria, adottato d’urgenza il 2 febbraio 2023. In particolare, nel corso delle interlocuzioni che hanno fatto seguito all’adozione del suddetto provvedimento e con specifico riferimento al profilo dell’age gate, la Società ha rappresentato di aver implementato su tutte le pagine di registrazione ai Servizi un age gate che limita l’accesso agli utenti che hanno compiuto 18 anni e che comprende un “periodo di raffreddamento” volto a impedire che le persone che non siano riuscite ad accedere attraverso l’inserimento di dati anagrafici reali inseriscano, immediatamente dopo, una data di nascita diversa.

La Società ha altresì rappresentato di aver pianificato lo sviluppo di un processo per utilizzare l’analisi del linguaggio al fine di individuare ed impedire l’utilizzo dei Servizi da parte di persone di età inferiore ai 18 anni.

Prima dell’intervento dell’Autorità, quindi, tutti gli utenti, compresi i minori di età, potevano iscriversi al servizio Replika ed utilizzarlo senza che venisse chiesto loro di sottoporsi ad alcuna verifica dell’età. Come già chiarito in sede di contestazione, ad avviso dell’Autorità, l’assenza di uno standard comune idoneo a garantire, in maniera certa e assoluta, l’efficacia di un modello di verifica dell’età dell’utente e la discussione tutt’ora in atto a livello europeo al riguardo, non possono essere considerate ragioni sufficienti ad escludere l’adempimento degli obblighi a cui è tenuto il titolare del trattamento, segnatamente quello di verificare l’effettiva capacità negoziale dell’utente ai fini della validità del contratto.